第十六讲:投影矩阵和最小二乘

上一讲中,我们知道了投影矩阵

举两个极端的例子:

- 如果

,则 ; - 如果

,则 。

一般情况下,

在第一个极端情况中,如果

在第二个极端情况中,如果

向量

回到上一讲最后提到的例题:

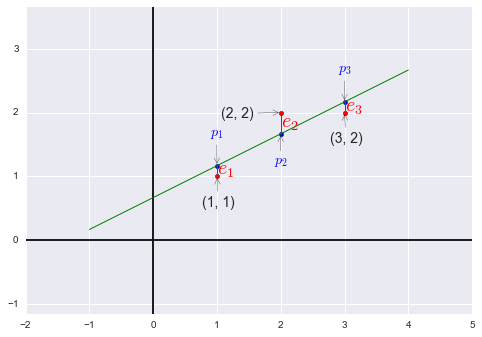

我们需要找到距离图中三个点

%matplotlib inline

import matplotlib.pyplot as plt

from sklearn import linear_model

import numpy as np

import pandas as pd

import seaborn as sns

x = np.array([1, 2, 3]).reshape((-1,1))

y = np.array([1, 2, 2]).reshape((-1,1))

predict_line = np.array([-1, 4]).reshape((-1,1))

regr = linear_model.LinearRegression()

regr.fit(x, y)

ey = regr.predict(x)

fig = plt.figure()

plt.axis('equal')

plt.axhline(y=0, c='black')

plt.axvline(x=0, c='black')

plt.scatter(x, y, c='r')

plt.scatter(x, regr.predict(x), s=20, c='b')

plt.plot(predict_line, regr.predict(predict_line), c='g', lw='1')

[ plt.plot([x[i], x[i]], [y[i], ey[i]], 'r', lw='1') for i in range(len(x))]

plt.annotate('(1, 1)', xy=(1, 1), xytext=(-15, -30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('(2, 2)', xy=(2, 2), xytext=(-60, -5), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('(3, 2)', xy=(3, 2), xytext=(-15, -30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('$e_1$', color='r', xy=(1, 1), xytext=(0, 2), textcoords='offset points', size=20)

plt.annotate('$e_2$', color='r', xy=(2, 2), xytext=(0, -15), textcoords='offset points', size=20)

plt.annotate('$e_3$', color='r', xy=(3, 2), xytext=(0, 1), textcoords='offset points', size=20)

plt.annotate('$p_1$', xy=(1, 7/6), color='b', xytext=(-7, 30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('$p_2$', xy=(2, 5/3), color='b', xytext=(-7, -30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('$p_3$', xy=(3, 13/6), color='b', xytext=(-7, 30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.draw()%matplotlib inline

import matplotlib.pyplot as plt

from sklearn import linear_model

import numpy as np

import pandas as pd

import seaborn as sns

x = np.array([1, 2, 3]).reshape((-1,1))

y = np.array([1, 2, 2]).reshape((-1,1))

predict_line = np.array([-1, 4]).reshape((-1,1))

regr = linear_model.LinearRegression()

regr.fit(x, y)

ey = regr.predict(x)

fig = plt.figure()

plt.axis('equal')

plt.axhline(y=0, c='black')

plt.axvline(x=0, c='black')

plt.scatter(x, y, c='r')

plt.scatter(x, regr.predict(x), s=20, c='b')

plt.plot(predict_line, regr.predict(predict_line), c='g', lw='1')

[ plt.plot([x[i], x[i]], [y[i], ey[i]], 'r', lw='1') for i in range(len(x))]

plt.annotate('(1, 1)', xy=(1, 1), xytext=(-15, -30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('(2, 2)', xy=(2, 2), xytext=(-60, -5), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('(3, 2)', xy=(3, 2), xytext=(-15, -30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('$e_1$', color='r', xy=(1, 1), xytext=(0, 2), textcoords='offset points', size=20)

plt.annotate('$e_2$', color='r', xy=(2, 2), xytext=(0, -15), textcoords='offset points', size=20)

plt.annotate('$e_3$', color='r', xy=(3, 2), xytext=(0, 1), textcoords='offset points', size=20)

plt.annotate('$p_1$', xy=(1, 7/6), color='b', xytext=(-7, 30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('$p_2$', xy=(2, 5/3), color='b', xytext=(-7, -30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.annotate('$p_3$', xy=(3, 13/6), color='b', xytext=(-7, 30), textcoords='offset points', size=14, arrowprops=dict(arrowstyle="->"))

plt.draw()

plt.close(fig)plt.close(fig)根据条件可以得到方程组

我们需要在

注:如果有另一个点,如

现在我们尝试解出

写作方程形式为

回顾前面提到的“使得误差最小”的条件,

解方程得

于是我们得到

误差向量

接下来我们观察

先假设

我们再来看一种线性无关的特殊情况:互相垂直的单位向量一定是线性无关的。

- 比如

,这三个正交单位向量也称作标准正交向量组(orthonormal vectors)。 - 另一个例子

下一讲研究标准正交向量组。

Ash Blog

Ash Blog