第三十五讲:期末复习

依然是从以往的试题入手复习知识点。

已知

矩阵 ,有 无解; 仅有唯一解,求关于 的信息。 首先,最容易判断的是

;而根据第一个条件可知,矩阵不满秩,有 ;根据第二个条件可知,零空间仅有零向量,也就是矩阵消元后没有自由变量,列向量线性无关,所以有 。 综上,有

。 根据所求写出一个矩阵

的特例: 。 :不相等,因为 可逆而 不可逆,所以行列式不相等。(但是对于方阵, 恒成立。) *

可逆吗?*是,因为 ,矩阵列向量线性无关,即列满秩。 *

正定吗?*否,因为 是 矩阵与 矩阵之积,是一个三阶方阵,而 秩为 ,所以不是正定矩阵。(不过 一定是半正定矩阵。) 求证

至少有一个解:因为 的列向量线性无关,所以 的行向量线性无关,消元后每行都有主元,且总有自由变量,所以零空间中有非零向量,零空间维数是 (可以直接从 得到结论)。 设

,对于 ,求 。 按列计算矩阵相乘,有

。 *若Ax=v_1-v_2+v_3=0,则解是唯一的吗?为什么。*如果解释唯一的,则零空间中只有零向量,而在此例中

就在零空间中,所以解不唯一。 *若

是标准正交向量,那么怎样的线性组合 能够最接近 ?*此问是考察投影概念,由于是正交向量,所以只有 向量最接近 。 矩阵

,求稳态。 这是个马尔科夫矩阵,前两之和为第三列的两倍,奇异矩阵总有一个特征值为

,而马尔科夫矩阵总有一个特征值为 ,剩下一个特征值从矩阵的迹得知为 。 再看马尔科夫过程,设从

开始, 。先代入特征值 查看稳态 ,当 ,第一项与第三项都会消失,剩下 。 到这里我们只需求出

对应的特征向量即可,带入特征值求解 ,有 ,可以消元得,也可以直接观察得到 。 剩下就是求

了,可以通过 一一解出每个系数,但是这就需要解出每一个特征值。另一种方法,我们可以通过马尔科夫矩阵的特性知道,对于马尔科夫过程的每一个 都有其分量之和与初始值分量之和相等,所以对于 ,有 。所以最终结果是 。 对于二阶方阵,回答以下问题:

求投影在直线

上的投影矩阵:应为 。 已知特征值

求原矩阵 :从对角化公式得 ,解之即可。 是一个实矩阵,且对任意矩阵 , 都不能分解成 ,给出 的一个例子:我们知道 是对称的,所以给出一个非对称矩阵即可。 矩阵 有正交的特征向量,但不是对称的,给出一个 的例子:我们在三十三讲提到过,反对称矩阵,因为满足 而同样具有正交的特征向量,所以有 或旋转矩阵 ,这些矩阵都具有复数域上的正交特征向量组。 最小二乘问题,因为时间的关系直接写出计算式和答案,

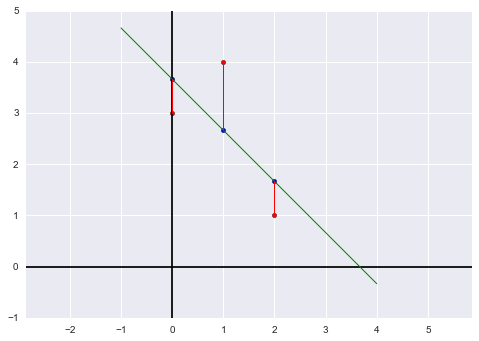

,解得 。 求投影后的向量

:向量 就是向量 在矩阵 列空间中的投影,所以 。 求拟合直线的图像:

时 所在的直线的图像, 即 。

%matplotlib inline

import matplotlib.pyplot as plt

from sklearn import linear_model

import numpy as np

import pandas as pd

import seaborn as sns

x = np.array([0, 1, 2]).reshape((-1,1))

y = np.array([3, 4, 1]).reshape((-1,1))

predict_line = np.array([-1, 4]).reshape((-1,1))

regr = linear_model.LinearRegression()

regr.fit(x, y)

ey = regr.predict(x)

fig = plt.figure()

plt.axis('equal')

plt.axhline(y=0, c='black')

plt.axvline(x=0, c='black')

plt.scatter(x, y, c='r')

plt.scatter(x, regr.predict(x), s=20, c='b')

plt.plot(predict_line, regr.predict(predict_line), c='g', lw='1')

[ plt.plot([x[i], x[i]], [y[i], ey[i]], 'r', lw='1') for i in range(len(x))]

plt.draw()%matplotlib inline

import matplotlib.pyplot as plt

from sklearn import linear_model

import numpy as np

import pandas as pd

import seaborn as sns

x = np.array([0, 1, 2]).reshape((-1,1))

y = np.array([3, 4, 1]).reshape((-1,1))

predict_line = np.array([-1, 4]).reshape((-1,1))

regr = linear_model.LinearRegression()

regr.fit(x, y)

ey = regr.predict(x)

fig = plt.figure()

plt.axis('equal')

plt.axhline(y=0, c='black')

plt.axvline(x=0, c='black')

plt.scatter(x, y, c='r')

plt.scatter(x, regr.predict(x), s=20, c='b')

plt.plot(predict_line, regr.predict(predict_line), c='g', lw='1')

[ plt.plot([x[i], x[i]], [y[i], ey[i]], 'r', lw='1') for i in range(len(x))]

plt.draw()

plt.close(fig)plt.close(fig)接上面的题目

求一个向量

使得最小二乘求得的 :我们知道最小二乘求出的向量 使得 列向量的线性组合最接近 向量(即 在 列空间中的投影),如果这个线性组合为 向量(即投影为 ),则 向量与 的列空间正交,所以可以取 同时正交于 的两个列向量。

Ash Blog

Ash Blog